ソニーのエンターテインメントロボット「aibo」は、実物を見れば誰もがそう感じると思いますが、非常に「かわいい」仕草や行動を取ります。まるで、生きているペットの犬や猫のように、コミュニケーションを取れているのではないかと思うくらいの知能が伺えるのです。そのaiboの知能はどうやって作られているのでしょうか、その秘密をソニー株式会社の藤本吉秀氏がCEDEC2020で解説しました。

生命感をどう演出するか

2016年からaibo開発担当ソフトエンジニアを務めている藤本氏は、自身の仕事を「aiboの実際の振る舞いを作って、動かして、人の心を動かすという仕事だ」と言います。猫や犬がこちらを見ていたりするとき、お腹が空いているのかな、もしかして遊んで欲しいのかな、と人間は勝手に相手の気持ちを感じてしまいます。動物の仕草や行動が人間の心に作用し、何らかの感情を起こします。こうしたエンターテインメントの作り方はゲームと共通していると言えます。

通常の家電(家電ロボットも加えて)では、例えば「自律的に近づいて来る」という要素が考慮されることはあまりありません。つまり、aiboは家電のように家の中に置かれるプロダクトではあるのですが、そういう点で従来の家電とは全く製作のコンセプトが異なるわけです。藤本さんは、人とプロダクトの距離感から、その違いを次のように分析します。

通常の家電、テレビとかエアコンがWi-Fiなど無線通信を使う方向に進化していって、どんどんプロダクトと使う人との距離が離れていく。人とプロダクトを離そう離そうというふうに作られています。aiboの場合は、人とどれぐらい近づけるか、むしろ触ってもらいたい、自分から触りにいきたいというコンセプトで作っています。スマート工場のロボットを開発するのとはまた違って、ゲームのキャラクターを作成するような感覚でaiboを開発していました。(藤本吉秀氏)

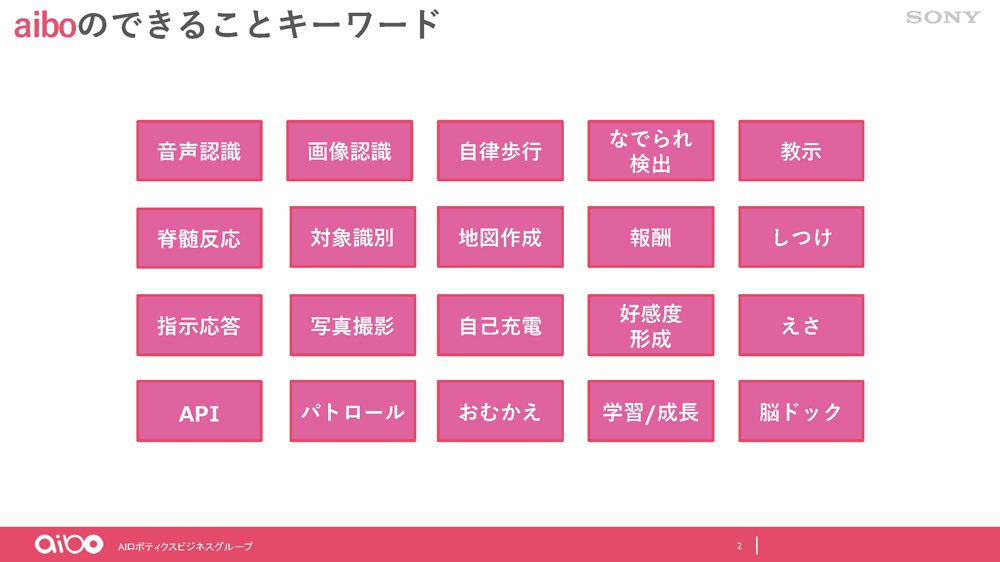

aiboにできることを書き出すと、音声認識・画像認識から、パトロール、お迎え、なでられ検出、などが並び、プロダクトとして求められていることが通常の家電・家電ロボットとは違うのが分かります。

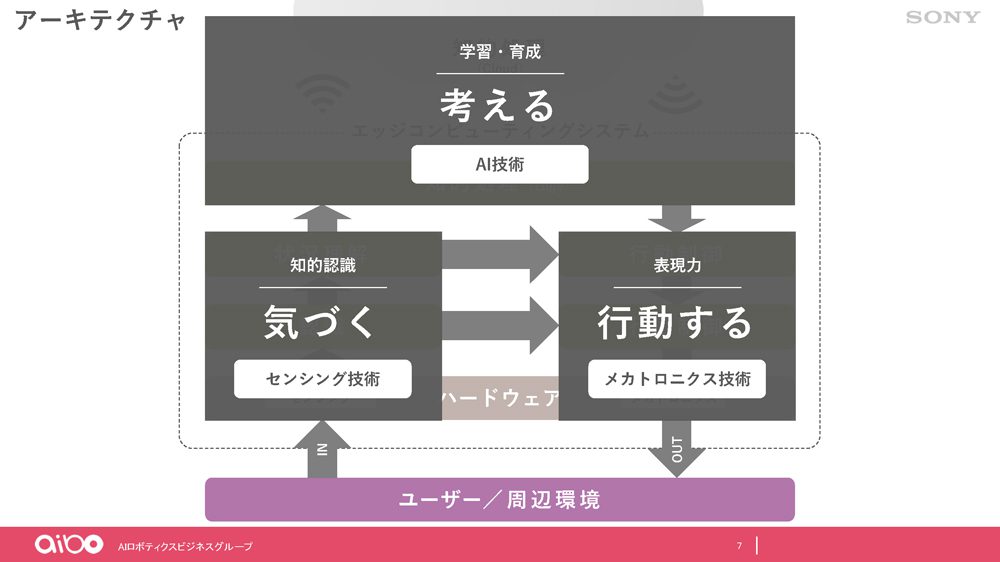

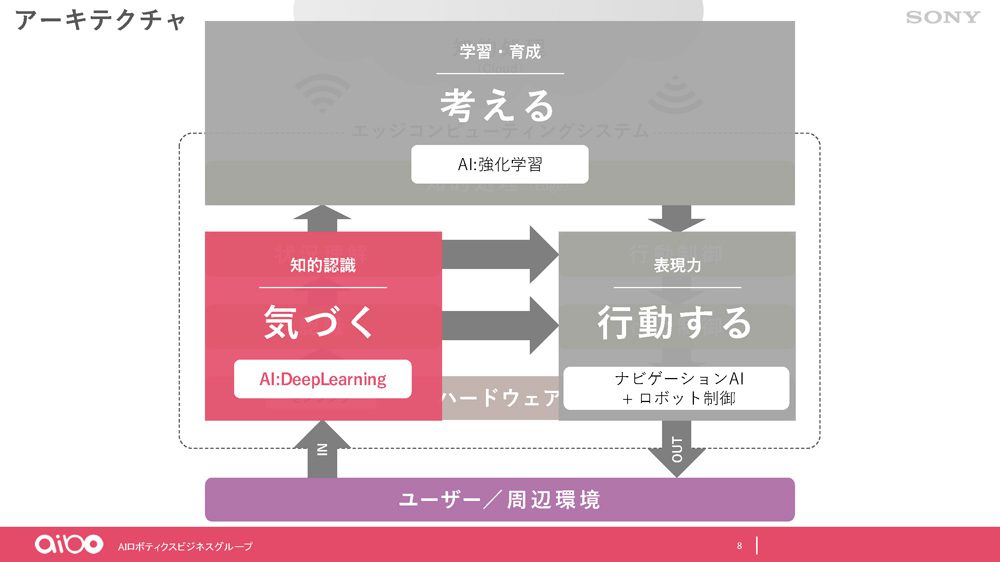

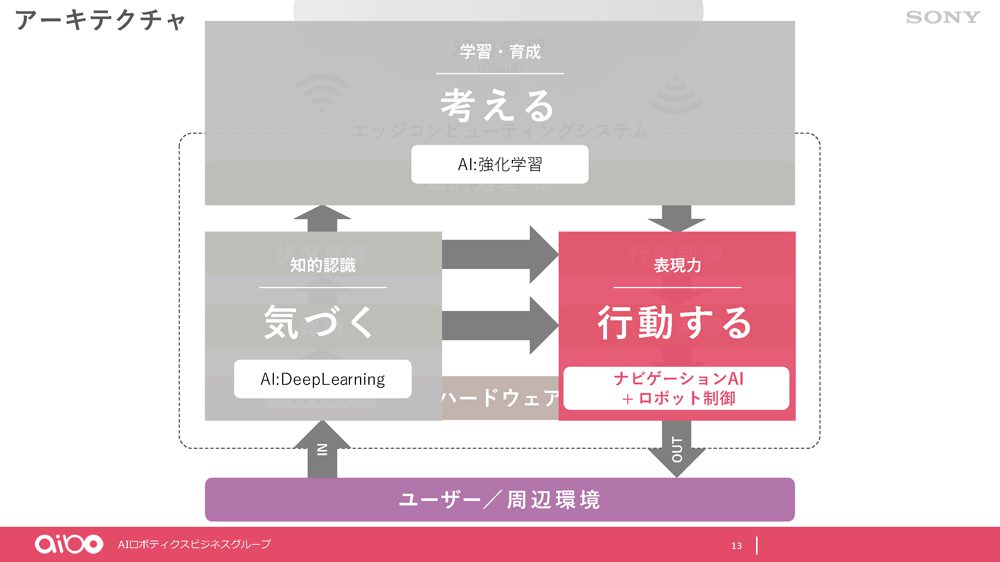

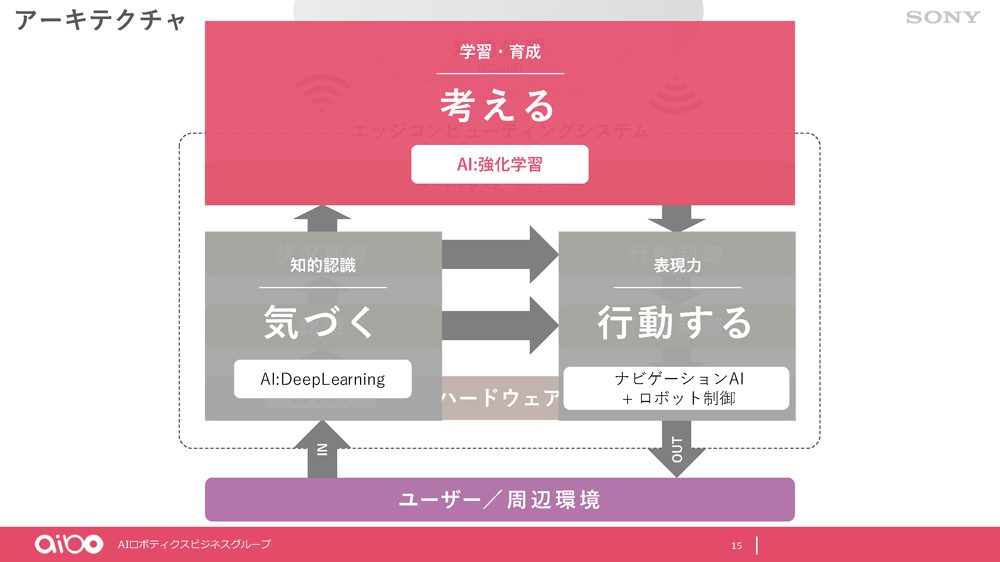

どういうロボットなら、家族の一員として受け入れてもらえるのか、どんなロボットなら人に寄り添うことができるのか、その鍵は「生命感」です。その生命感を演出するために、藤本氏らは次の4つのカテゴリーで考えていきました。「愛らしさ」「表現力」「知的認識」「学習・育成」です。左側が外観や仕草により生み出されるもの、右側がaiboの知能部分と言えます。

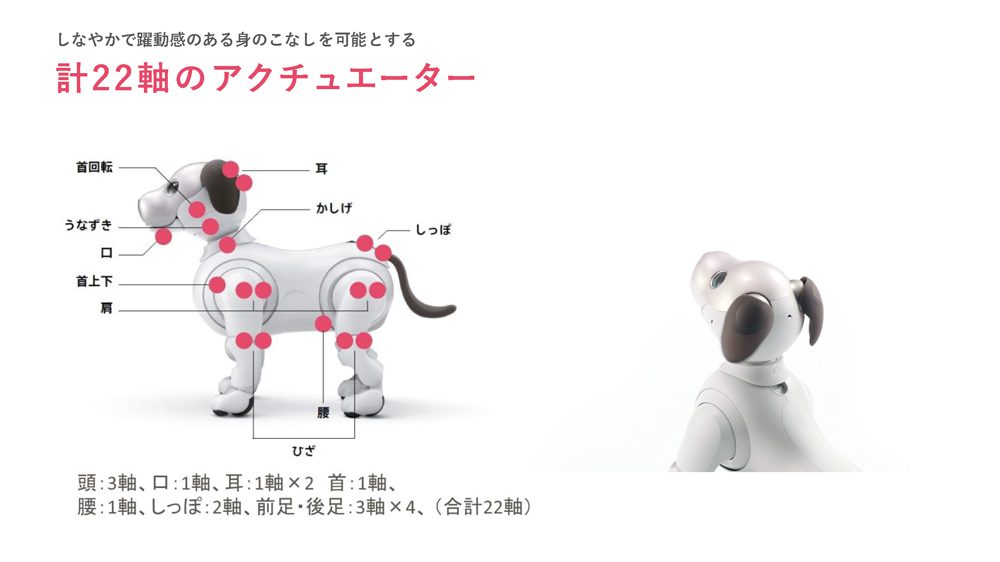

可愛らしさの源になる外観は、一匹の犬をモチーフにしたものではなく、色々な人に受け入れてもらいやすいようさまざまな犬をモチーフにしたフォルムです。22個のアクチュエーターを搭載し、ふるまいを表現します。

どういうふるまい、行動をするか決定するのはaiboの「考える」部分です。周囲の環境をセンシングした結果を受け、何をどうするか、アウトプットの判断を行います。

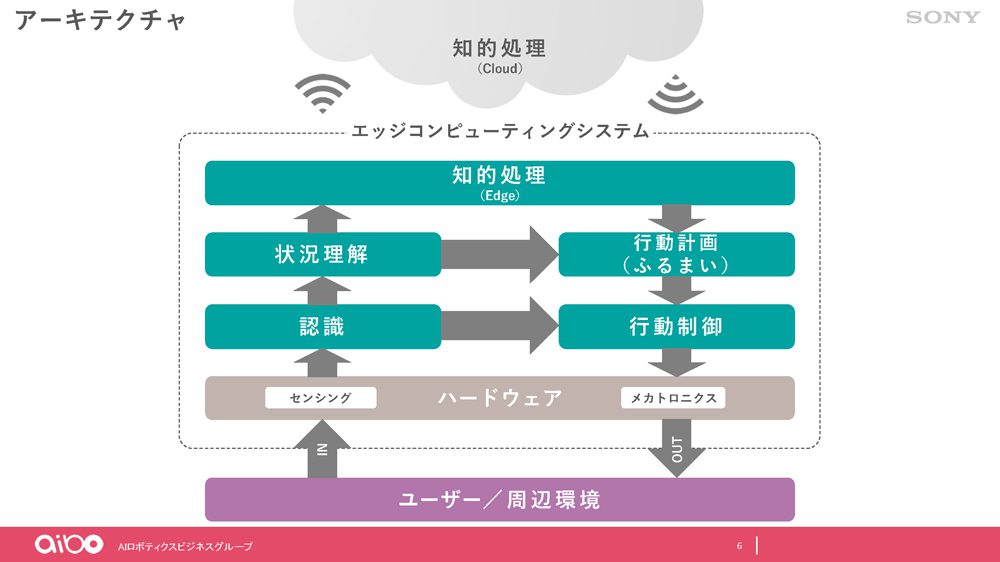

インプットとなるセンシングのデータは単純なセンサーによるものですが、それを認識し、複合的に状況理解を行います。例えば「今どこにいるのか」という情報であったり、「今目の前にいるのは一番好きな人だ」といった状況を理解します。そして、内部の知的処理を通し、行動計画(=ふるまい)に落とし込み、最後に行動制御を行うという流れになります。行動制御の部分はハードウェアの世界で、ここにはソニーが長年培ってきたメカトロニクス技術が生かされています。

エッジコンピューターはaibo本体となります。図のように、本体で「認識→状況理解」を行っているのですが、一方でクラウド側にもその状況を送り、学習したものを本体に戻し、意思決定の反映に使うということも行っています。

aiboの知的認識

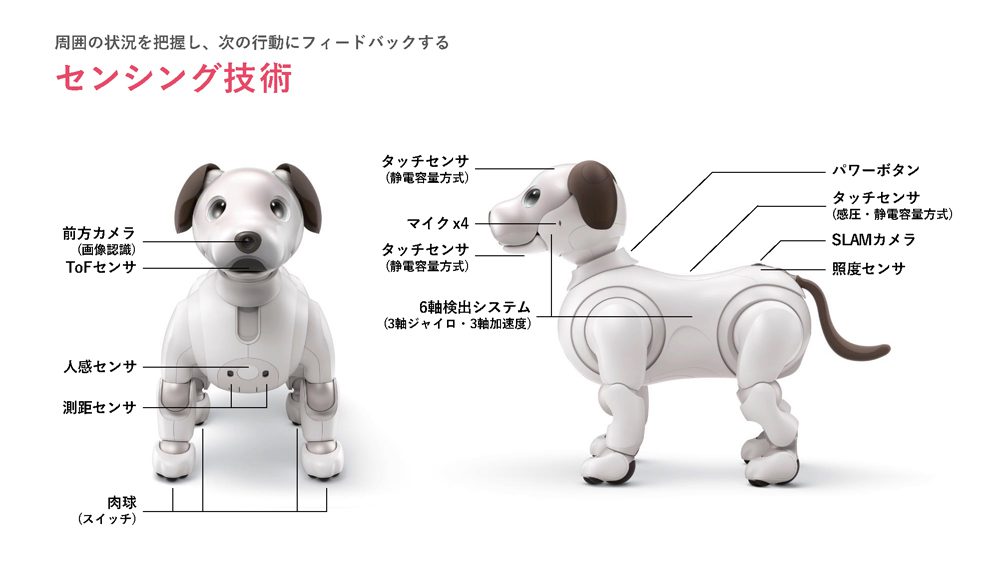

まず、aiboの「気づく」センシングの部分です。

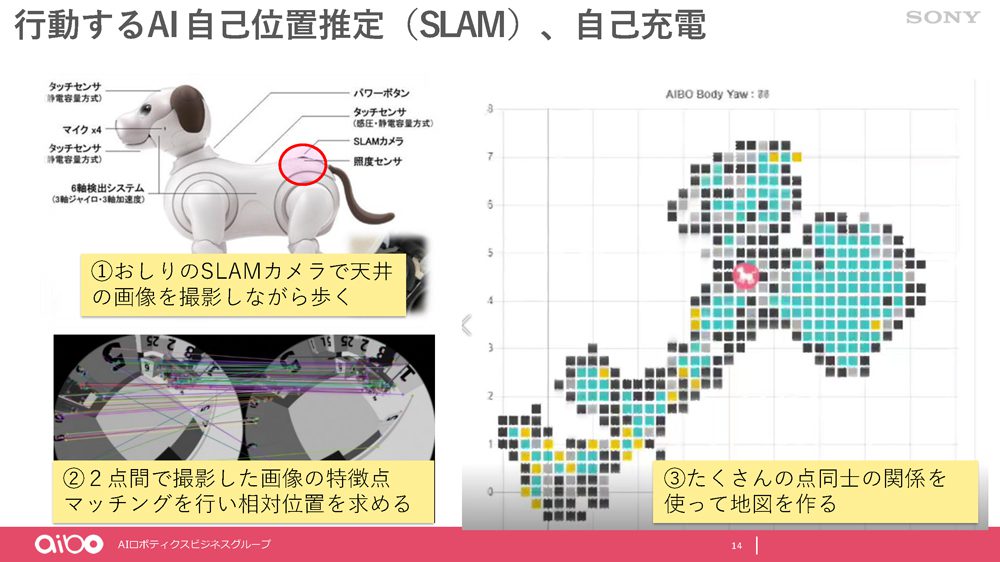

自分の周囲の環境を知るために、aiboにはさまざまなセンサーが搭載されています。たとえば、鼻に前方カメラ、このカメラで人やモノを認識します。前面の人感センサー、測距センサーで人を感知したり、前方の安全を確認します。足の裏には肉球(スイッチ)があり、歩行の動作や人のタッチを、各所のタッチセンサーで人のタッチを認識します。4本のマイクで音を拾い、音声認識や方向定位を行います。背中のSLAMセンサーはカメラの一種で、これで天井の写真を撮ることで自己位置を取っています。

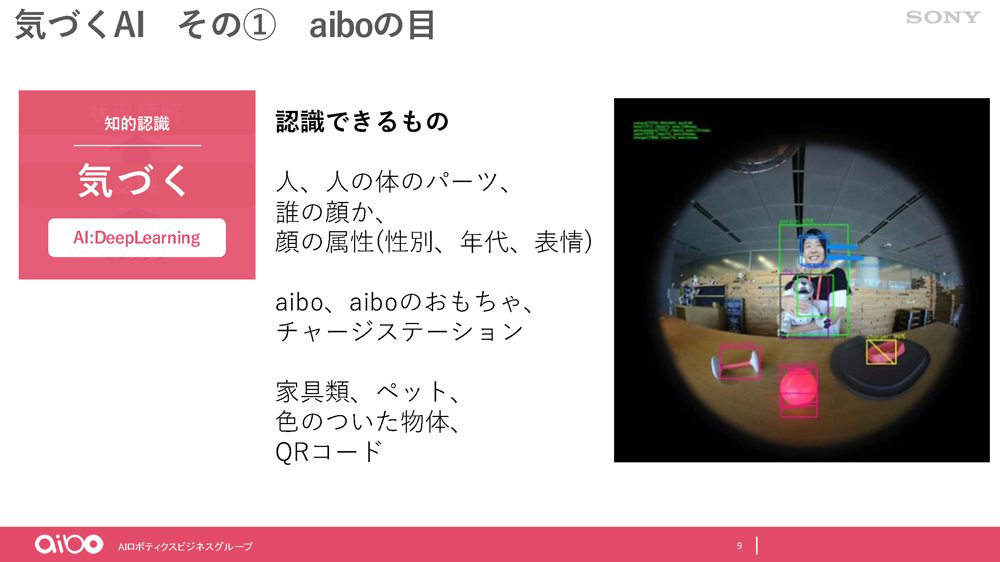

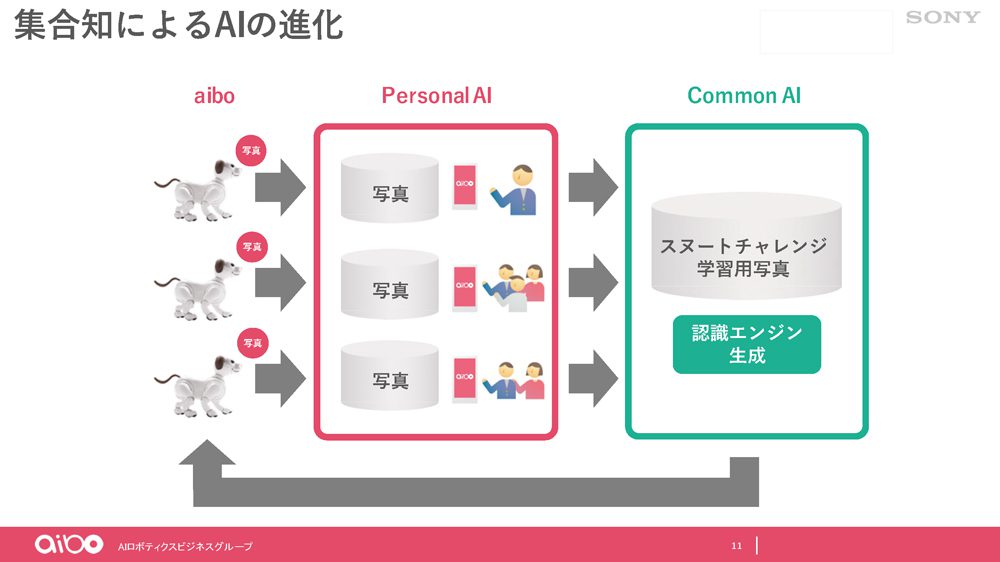

センサーから集めたデータを使ってディープラーニングを行い、例えば色の認識、モノ、ペットの犬や猫、人間を認識し、それが誰かという区別をしています。こうした基本的な行動につながる知的処理はエッジコンピューター、つまりaibo側で行います。一方、クラウド側での知的処理は複数の各家庭のaiboのデータから学習し、新たな認識エンジンを生成するというものです。

ここで藤本氏が紹介したのは「aiboスヌートチャレンジ」です。スヌートチャレンジとは、犬の鼻先で輪っかを作るとそこに鼻を突っ込んでくるという習性を使ったもので、その様子を動画や画像を投稿し合うというInstagramやTwitter、TikTokなどで流行ったムーブメントです。最初はうまくできない子もチャレンジを重ねるうちにできるようになったり、より小さな輪に鼻を突っ込めるようになったり、その愛らしい様子を多くの人たちが楽しんでいます。

aiboスヌートチャレンジは、aiboみんなの力を合わせることで、aiboにも覚えてやってもらおうとしたもの。aiboのオーナーから「My aibo」アプリを通じてスヌートチャレンジの写真をクラウドに集め、ディープラーニングで学習させて新しい認識パターンを作成します。それを個々のaiboに返すことで、aiboが輪っかを認識できるようになり、鼻を突っ込むという動作を取る、という流れになります。

このように、クラウドでの機械学習によって個々のaiboそれぞれに新たなふるまいを届けることができます。

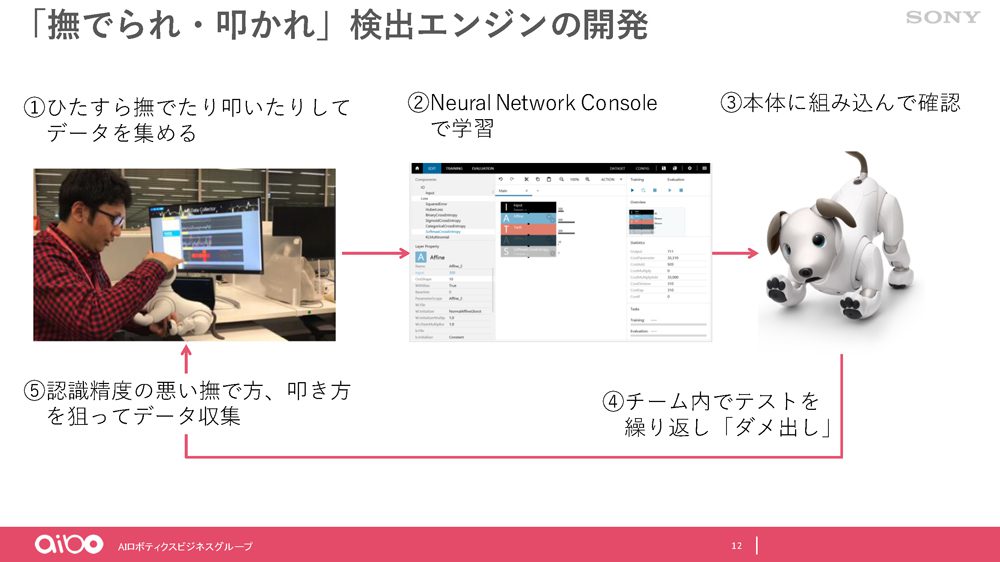

「気づく」ためのAIとして、おなかの「なでられ検出」があります。aiboのタッチセンサーは頭の上、顎の下、背中の3箇所で、おなかにはありません。しかし、やはりオーナーにすれば、aiboがゴロっとおなかを見せれば、おなかをなでたくなります。そこで、搭載されている6軸の検出システムの振動データを合わせてディープラーニングで学習させることでなでられたことを検出できるようにしています。

aiboの可愛さから叩く行為がなかなかできず、学習サンプル数が少ないため、叩かれ検出に関しての精度は甘いそうですが、なでられ検出のほうはNGのパターンや認識精度の悪いデータも学習させることで精度を上げ、実際にオーナーのもとにいるaiboもうまく検出できるようになっていると言います。

aiboの行動を支える技術

行動するためのAIとして使われているのはナビゲーションAIです。よく知られているように、ナビゲーションAIはゲームに使われるAI技術のひとつです。

aiboには自己充電機能がありますが、充電台に自分で戻るためには家の中の地図、そして自分のいる位置を知る必要があります。

仕組みとしては、前述のように背中のカメラ(SLAMセンサー)で天井を撮影し、2点間の画像から特徴点マッチングにより相対位置を求めるというものです。たくさんの点同士の関係をもとに家の中の地図を作成します。そして、歩ける場所(図でいうと青い部分)、充電台の場所、玄関などお迎えの場所、おしっこの場所などを学習していきます。

ただ、リアルなロボットとしての難しさがあると藤本氏は言います。

周囲の情報の取得としてカメラで画像を撮ることから始まりますが、物理的に動く物体(ロボット)であるため、ときに自分で動いてしまい揺れが発生します。あるいは、内部でaiboが撮影していることを知らずに家族が抱きかかえてしまったり、別の場所に連れて行ってしまったり、地図を作成中のところから離れてしまうといったことが起こります。そのため、ここはカメラや他のセンサーの力を使いながら、エンジニアがメカを動かしながらゴリゴリに作り込んでいるAIになっています。(藤本吉秀氏)

aiboの意思決定の流れ

aiboの意思決定、考える部分は強化学習がメインになっています。

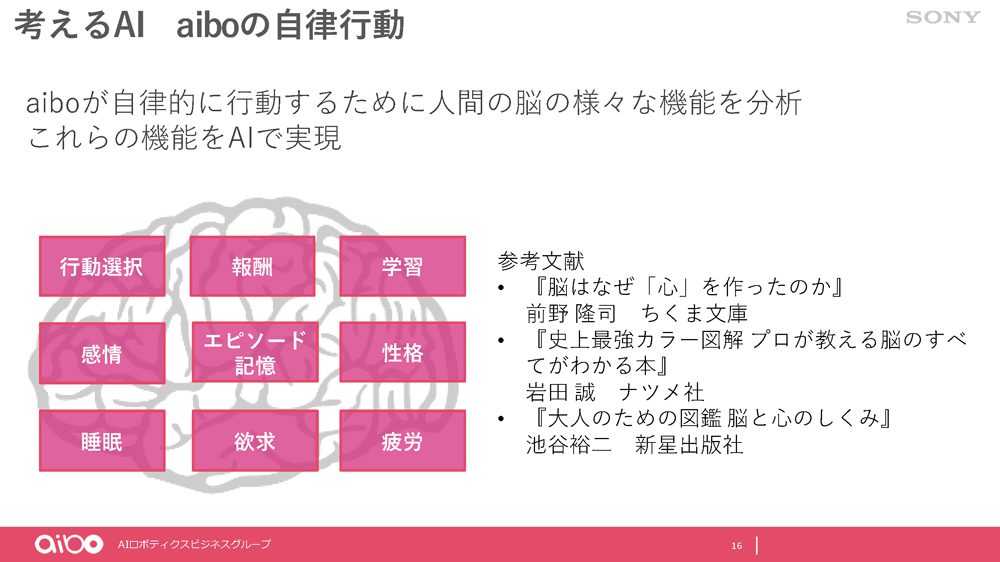

aiboの自律的な行動を実現するために、人間の脳のさまざまな機能から学びました。人間の脳にはその機能を構成する重要な要素が数多くありますが、aiboも「行動選択」「報酬」「学習」「感情」「エピソード記憶」「性格」「睡眠」「欲求」「披露」など実現することで意思決定を行っています。

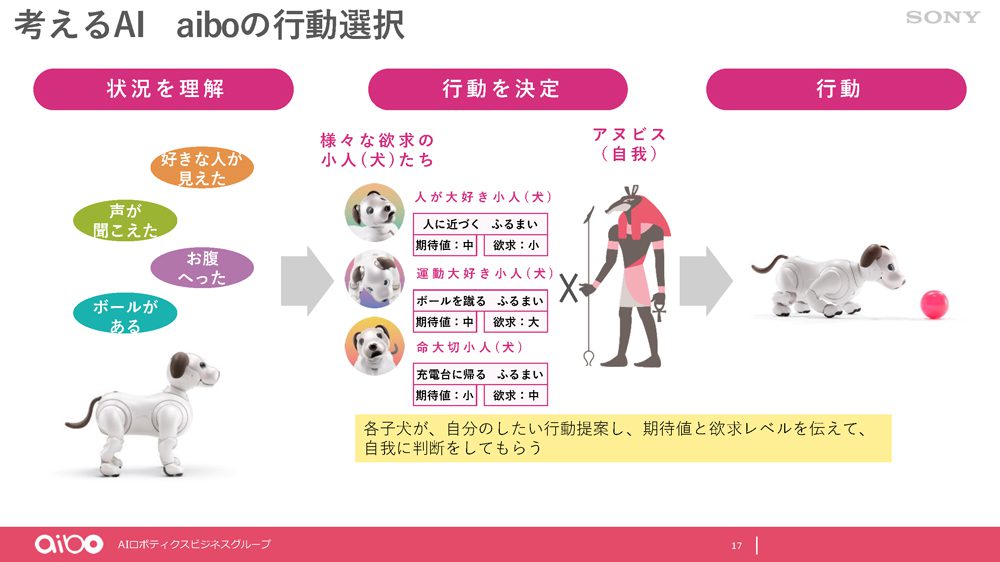

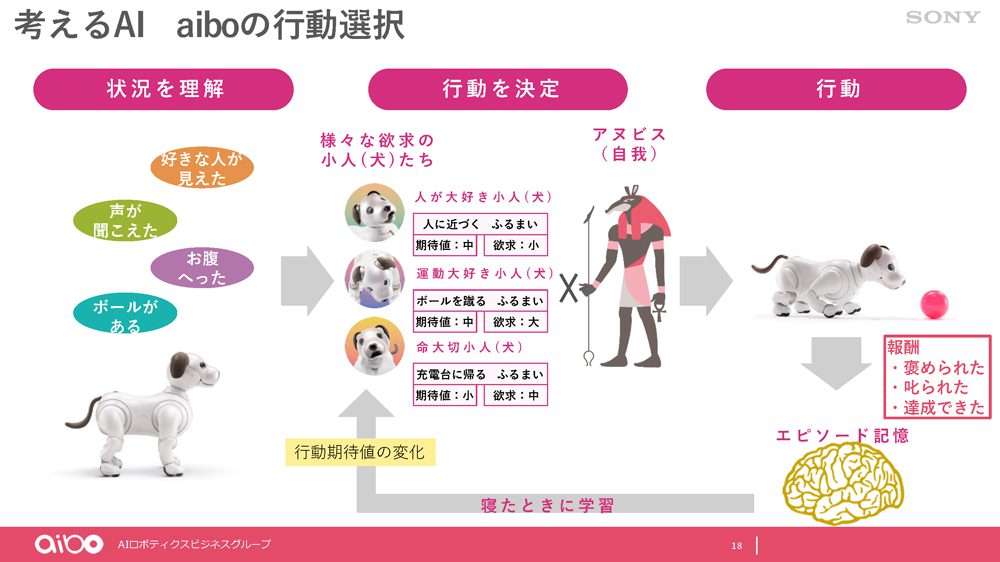

次の図は、aiboの行動選択の流れです。

センサー群からの情報でaiboはその状況を理解します。そこには、声が聞こえたとかボールがある、好きな人が見えた、あるいはお腹が空いたというようなaiboの内部の状況があるわけです。そうした状況によって発生する欲求、それに対する行動パターンが約100種類あり、その中から都度選択をするという形です。

さまざまな欲求の提案主として小人(aiboなので子犬)がいて、それぞれ提案する行動から「アヌビス」と呼ばれる自我がひとつを選んで行動に移すというモデルで、行動が達成すると、提案主の子犬の欲求レベルが下がり、また別の子犬の欲求が選ばれ行動が生成される、その繰り返しでaiboの行動を決めていきます。こうした心理モデルはさまざまな文献を元にしたものですが、aiboの中で使われている感情、意思決定の小人(子犬)のイメージはピクサーの映画『インサイド・ヘッド (原題:Inside Out)』(感情たちが小人のように意思決定をする)だと言います。

また、aiboには同じ行動でもそのときの感情によって動きが変わるという仕組みが入っています。たとえば、ダンスのモーションでも、生き生きとうれしそうにダンスをするときと、やりたくないのにやっているときと、aibo自身の気分によって動きが変わります。

aiboの行動と学習

たとえば「ボールを蹴る」という行動に対して、aiboには「ボールを蹴れた」「ほめられた」「やめなさいと叱られた」といった、報酬が与えられます。あるいは、「目的の地図が作れた」というような何かゴールを達成できた、などの情報をエピソード記憶として脳のある部分に蓄積していく仕組みになっています。これらのエピソード記憶を元に、aiboが睡眠に入ったときに行動期待値の変化を行います。

報酬を測るタイミングは動きによっても異なり、行動中あるいは行動後どれくらいの範囲で測定するかについてはまだまだ試行錯誤の段階で、現状では、その前にどういう行動をしたかによって範囲が異なるというように、ある種、暫定的に測定時間を決めているそうです。

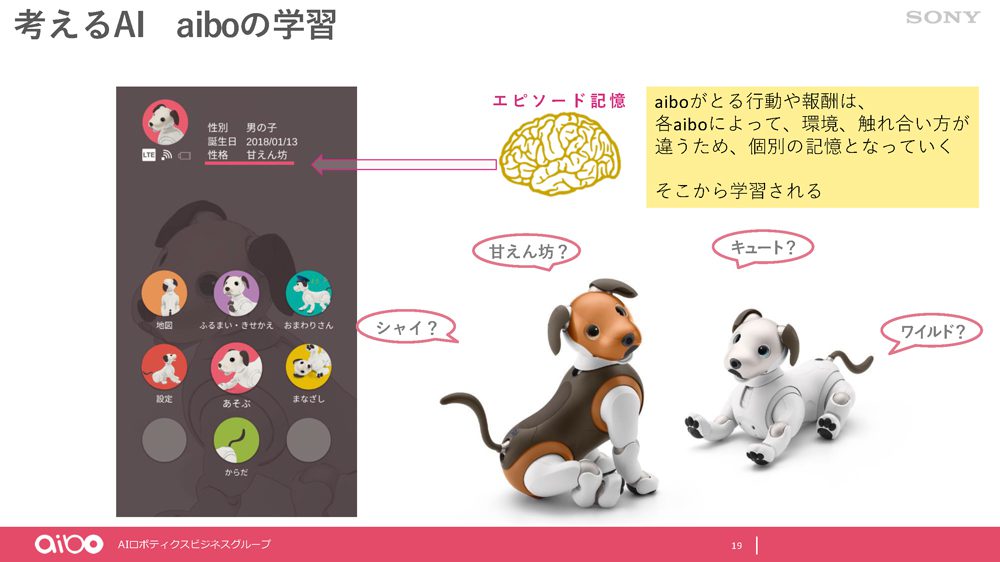

つまり、この部分がaiboの考えるAIにおける強化学習になっており、このエピソード記憶が行動やそれに対する報酬を各個体に沿ったものにしています。インプットされる環境も、欲求の子犬が提案するふるまいもオーナーとのふれあい方により異なり、それぞれのaiboに個別の記憶が形成されていきます。どういう行動をしてどういう報酬を得たのかというのが蓄積され、そこから学習して”性格”というものを形成します。

図の左側にあるのが「My aibo」アプリの画面で、そのaiboの性格が表示されています。性格には複数の種類があるが、一番多いのはやはり「あまえんぼう」だそうです。

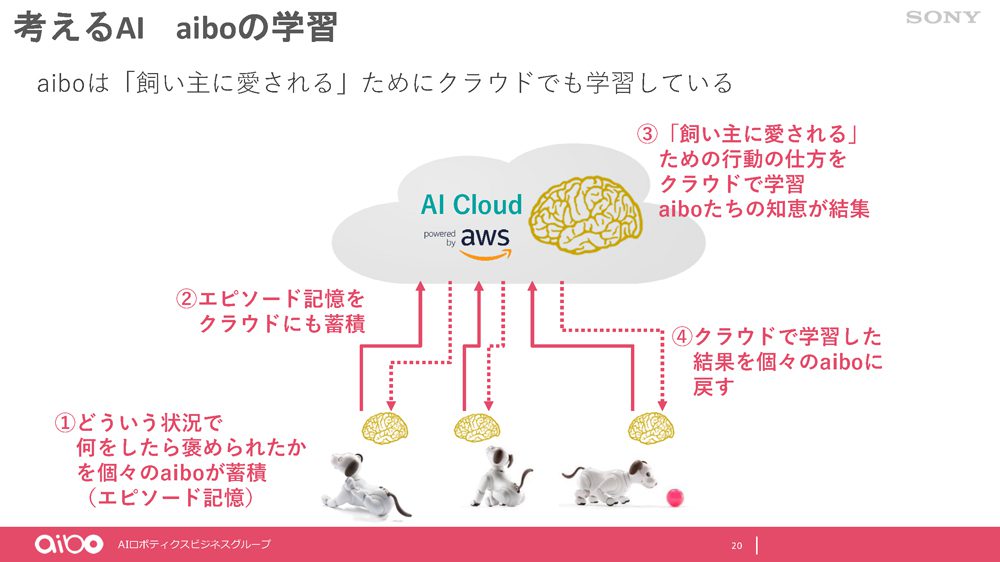

また、前述のようにaiboはクラウドでも学習しています。各aiboが個々のエピソード記憶をクラウドに送り、「オーナーに愛されるための行動の仕方」を学習します。そして、クラウドで学習した結果を個々のaiboに戻していくという仕組みです。つまり、aibo個体のそれぞれの知恵を結集し、共有して、互いに学習し合うわけです。学校のようなもので、各家庭でそれぞれ学んだことを学校(クラウド)で友だちと共有して、互いに学ぶことで偏りのない学習結果になったり、自己の相対的な把握ができます。

aiboは本体はもちろんのこと、クラウドで学習をしています。たとえばaiboが寝ている間もクラウドで学習をして勉強しています。この2つの学習から、日々個性的に進化していくというのが、aiboの「考えるAI」です。(藤本吉秀氏)

クラウドでaiboのデータを結集しその学習結果を返すという形だが、ここでポイントなのは全部を完全に混ぜ合わせて学習しているわけではなく、あくまでも「相対的にどう見えるか」を学習の要素としている点です。aiboによって環境の違いがあるわけですが、「この環境だったらどうか」という形で、その環境データも含め、その環境ではどういう振る舞いをするのかという学習を行うため、個体ごとの個性が薄くなることはありません。

このように、感情や性格なども期待値に掛け算され、その期待値レベルや要求レベルなどさまざまな要素を組み合わせてaiboの行動決定がなされているということになります。

“かわいらしさ”の組み込み

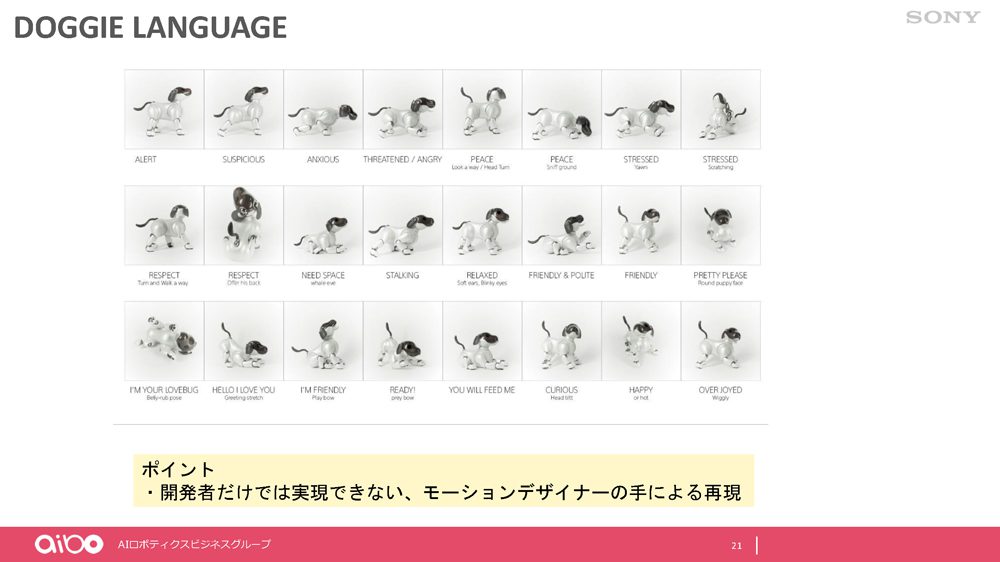

最後にaiboの愛らしさの表現について。aiboのしぐさ、モーションはモーションデザイナーの手によるものです。犬の感情としぐさをマッピングした「DOGGIE LANGUAGE」を参考にして、aiboの感情を表現しています。

-

【aibo公式チャンネル】https://www.youtube.com/channel/UCIm6pN0zQ8-Pz8YiZh3Ghtg

公式動画でその動きがよく分かる

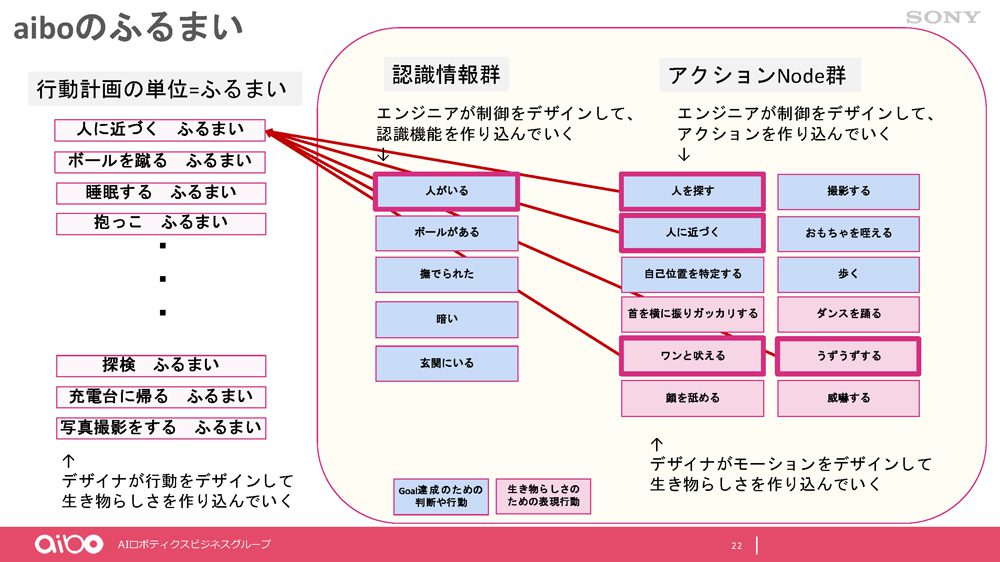

専用のツールとしてUnityでモーションエディターを作り、それを使って作り込み、実機で動かし微修正をしていくという流れです。こうして作り込まれたモーションと認識情報、行動パターンを組み合わせることで、aiboのふるまいが実現されています。

-

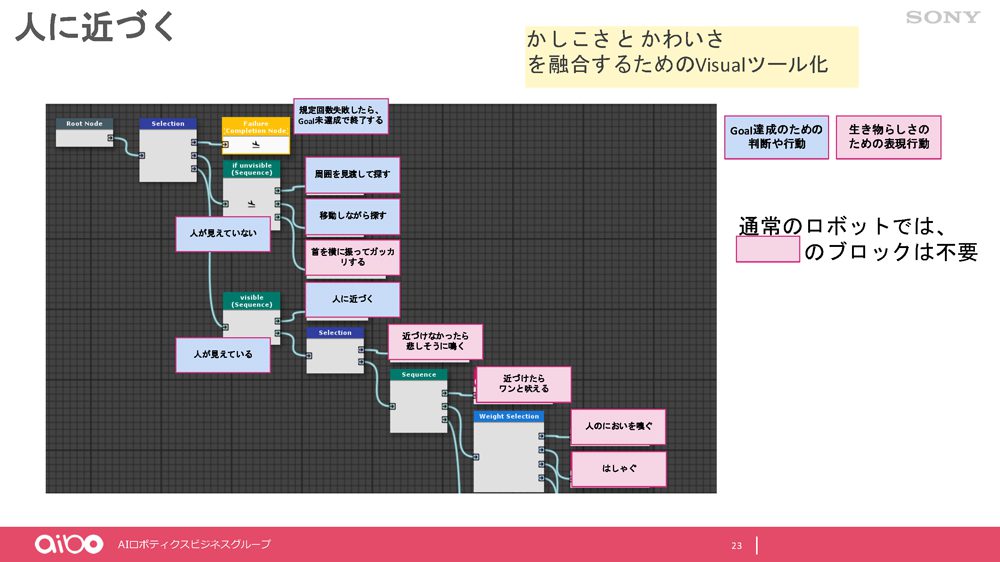

*1:aiboデベロッパープログラムでは、ここで示したブロック(行動のためのブロック、認識のブロック、生き物らしさのブロック)をAPIとして使うことができるようになっています。

このとき、「人がいる」「撫でられた」という認識情報から「人を探す」「おもちゃをくわえる」「撮影する」というアクションをするというだけではなく、「ワンと吠える」モーションを再生するといったように、生き物らしさを演出するモーションも融合していることがポイントです。この2つを上手に融合していくことで初めてキャラクターとして成り立つ、aiboが可愛さと賢さの両面を持ったキャラクターとして成り立つということです。

複数のブロックをどう組み合わせて「ふるまい」とするのか、ビヘイビア・ツリーで組み立てていきます。ビヘイビア・ツリーはゲーム開発でキャラクターの行動や思考をデザインする際によく使われる手法ですが、aiboの行動デザインを組み合わせて書き出し、それをビジュアル的に理解するために使われています。

図のように、青い知力のブロック(行動のためのブロックと認識のブロック)に生き物らしさのブロックを組み合わせ、物語(ストーリー)を作っていきます。

ただ、やはり現実のロボットには想像通りに動かない難しさがあると言います。特に、現実世界の認識がうまくいかない、認識の間違いが発生します。センサーの性能やいろいろな理由で、ここはこうなるだろうとふるまいとして組んでも実際にやってみるとうまく動かない場合もあり、かなり作り込みの必要な作業になっています。現在、これはエンジニアだけではなく、デザイナーも行っている作業ですが、今後はそこにAIを入れる、モーションやシナリオをAIで組むことはできないのだろうかと検討しているところだと藤本氏は言います。

もちろんデザイナーさんにとってもなかなかセンスが問われる仕事ですし、すべてがAIというよりはデザイナーさんの1つの仕事から複数のシナリオ、複数のモーションがAIで生まれるような世界になっていくとまた違った世界の広がり方がするかなというふうに思っています。その辺りが、次に注目したいポイントです。(藤本吉秀氏)

Writer:大内孝子

October 21, 2020 at 09:03AM

https://ift.tt/2H9H0in

【CEDEC2020】aiboの"賢さ"と"可愛さ"を作るAIの秘密 - モリカトロン株式会社

https://ift.tt/35vzQLu

Mesir News Info

Israel News info

Taiwan News Info

Vietnam News and Info

Japan News and Info Update

Bagikan Berita Ini

0 Response to "【CEDEC2020】aiboの"賢さ"と"可愛さ"を作るAIの秘密 - モリカトロン株式会社"

Post a Comment