撮影:Business Insider Japan

サイバーエージェントが突如、オープンソースとして無償公開した大規模言語モデル(LLM)「OpenCALM(オープンカーム)」が話題を呼んでいる。

国内の大手IT企業が、研究、商用など目的を問わず使用できる大規模言語モデルを公開するのは非常に珍しい試みだからだ。

今、国内の生成AI業界では、日本を軸にした新たな動きが活発化している。

サイバーエージェントと同日の5月17日にrinna社からも独自のLLMがオープンソースで登場したり、22日には東京工業大学と富士通などが2023年度中にスーパーコンピューター「富岳」を使い、和製生成AIを開発すると公表した。

なぜサイバーエージェントがLLMを作り、オープンソース化したのか。その狙いをAI事業本部の開発チームに聞いた。

ChatGPTが流行する前から「1年以上学習させていた」

取材に応じた、AI事業本部 AIクリエイティブDiv 統括の毛利真崇氏と、同機械学習エンジニアの石上亮介氏。

—— 5月17日の発表を見て、少なからず「なぜサイバーエージェントからLLMを?」と考えた人もいそうです。大規模言語モデルを自社開発することを決めた背景を教えてください。

毛利真崇氏(以下、毛利):我々はAI事業本部として、いくつかのミッションを進めていくなかで、2017年から広告のクリエイティブを支援するAI開発に取り組んできました。

バナー広告で使う画像や、言葉(キャッチコピー)などを組み合わせたものを(広告業界では)「クリエイティブ」と呼んでいますが、これをデザイナーが作るときに、どんな言葉とどんな画像を組み合わせるべきか、というのは人間がやってもかなり難しいんです。これをまずAIを使うことで効率化しようと。

その流れの中で、2021年に機械学習エンジニアの石上から、大規模言語モデルも扱いたいという提案があり、スタートしました。

石上亮介氏(以下、石上):広告バナーは画像・テキストが組み合わさっているため、2021年当初から「大規模言語モデルに限定せず、基盤モデル(ファウンデーションモデル)を作りたい」という話をしていて。社内で活用するための研究として始めました。

2022年夏頃、MidjourneyやStable Diffusionが登場した時に、生成モデルが注目を集めたことで開発が後押しされていきました。

また、日本語の大規模言語モデルとしては、先行事例として(AI企業の)ABEJAさんやrinna(りんな)さんがオープンなモデルとして公開しているという流れもありました。私たちもこういう(開発者)コミュニティに貢献していって、日本語における大規模言語モデルを一緒に盛り上げたいと思っています。

—— オープンソースで公開されたことはものすごく意義深いと思ってます。ただ、上場企業のプロジェクトで「無償公開する」という意思決定は難しいケースもあるのでは。いつくらいにオープン化すると決めたんですか。

毛利:LLMをオープンソースで公開したいとは、研究当初から考えていました。4月末から本格的に担当役員と議論を重ね、5月に入り、役員決裁を得られてすぐに、プレスリリースを出しました。

—— 何がハードルになったのでしょう。

毛利:上長がAI Labの担当役員でもあるのでオープンソースに対する理解は非常にありました。ハードルというよりは、「公開したあと、オープンソースのコミュニティーに我々がちゃんと貢献しきれるのか」がポイントでした。

リリースして終わりにならず、次(の版)などの計画があるのかと。その意見の回答を用意して、公開できるようになりました。

—— 「学習」にはどれくらいの期間をかけてますか?

撮影:Business Insider Japan

毛利:学習にかかった期間で言うと、SNSでは短期間で作ったみたいにおっしゃる人もいるんですが、実はいろんなモデルを1年以上学習させています。

元々社内にはオープンにしていないクローズドな「CALM」(CyberAgent Language Modelsの略)があり、これを色々な目的に合わせてチューニングしながら使っています。

—— 開発チームは、石上さんが中心になっていて、外部の提携事業者などは使われていない?

毛利:そうですね。LLMに関しては石上を筆頭に数人のチームという感じですね。

「和製LLM」を創り出すための課題

—— 社内向けのクローズドなCALMというのは、おそらく公開されている「68億パラメータ※」のものよりも大規模なものだと想像します。どういう使い分けで、どのように使われているんでしょうか?

※編注 パラメータとは:パラメータというのは、ごく簡単に言えばLLMが学習しているデータの大きさのこと。数が大きいほどLLMが賢くなる傾向がある一方、動作させるシステムが高価になる。また、最近の研究では、パラメータ数が少なくても精度が高いと判断されるものも現れている。ChatGPTにも使われているGPT-3は1750億パラメータ。

毛利:そうですね、クローズドのものは既に130億パラメータまでの開発が完了しています。

「極予測AI」として、既に発表させていただいているものは、2022年から実際に使っています。ただ、規模が大きくなれば精度も上がるんですけど、その分、推論に時間がかかったりします。(ですので)目的に合わせて、使用するLLMの規模を変えているという感じです。

石上:技術的な観点で言うと、オープンな(文章)データというのは、日本語だと特に限られていて、「学習させるべきデータが不足している」という感覚はあります。

どんなコーパス(文章データ)を学習させるかによって(LLMの)性能というのはかなり変わってくるので、これは一社で取り組むというよりは日本全体で取り組んでいくべき問題だと思っています。

毛利:(ちなみに)CALMでは当社独自のコーパスで学習させたりもしています。

—— 例えばどんなコーパスですか?

毛利:例えば、「LINEに掲載するテキストは疑問符で終わりがち」だったり、「Facebook(向けの広告クリエイティブ)だと、同じものでも少し真面目な表現に」なったりという特徴が異なっていたりします。

石上:自社のLLM(CALM)をベースに、媒体の特性に合わせてファインチューニング(追加学習による微調整)をするという感じです。

AIによる「広告クリエイティブ生成」を実戦投入

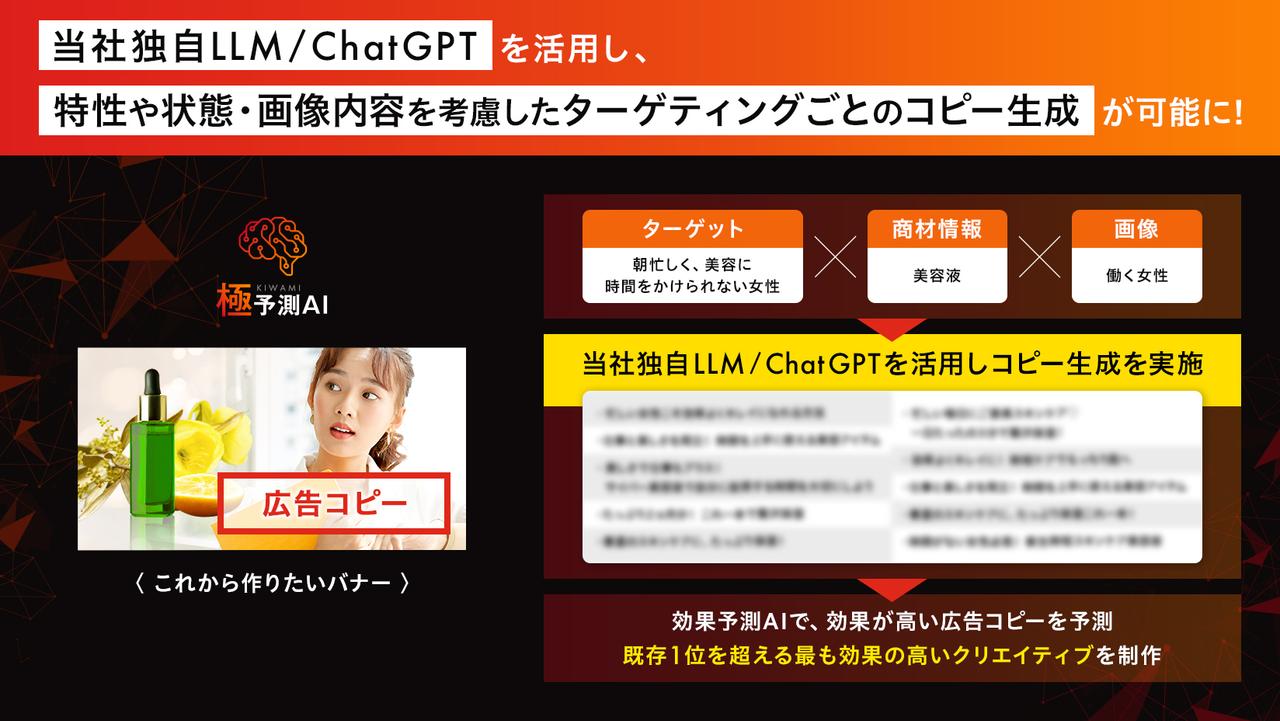

サイバーエージェントは5月18日に「極予測AI」でバナー広告などのキャッチコピーの自動生成機能を実装したことも発表している。社内でもLLM活用はどういうフェーズにあるのだろうか。

撮影:Business Insider Japan

—— LLMは既に、インターネットで配信しているバナー広告などにも使い始めているのでしょうか。

毛利:結構使っていますね。特に検索連動広告に出てくるようなバナーはほぼ使っています。もちろん人間がチェックしていますが。

ちょっと実際の画面は記事でお見せできないんですが、「極予測AI」では、ある商品があったら、その商品のクリエイティブに使うべきキャッチコピーの候補などをリアルタイムで生成します。そして、「生成されたもののなかで、高い効果が見込めそうなもの」をAIがさらに絞り込んで提案します。

その中からデザイナーが選んでバナーを作ると、そのバナーをAIが評価して「当たり率」を推定します。

「極予測AI」を使った、バナー広告のキャッチコピー生成のイメージ。5月18日発表のプレスリリースより。

出典:サイバーエージェント

——「当たり率」というのは、いわゆるCTR(クリック・スルー・レート。クリックされやすさの指標)とは違うものですか?

毛利:はい、「既に使われている広告の中で、最も効果が高いことが分かっている広告」よりもパフォーマンスが高い広告が作れる割合を「当たり率」と呼んでいます。(従来、人間のデザイナーだけがやっていた)3年ほど前と比較すると、AI生成を用いた「当たり率」は2倍になっています。

—— それは凄いですね。しかも、AIが決めたクリエイティブだと、人間の責任者のように「好き・嫌い」がないので説得しやすそうです。

毛利:特にクライアント企業には説明しやすくなったと聞いています。クライアント企業に「今AIだとこれがスコア良さそうなのでやってみませんか?」とアプローチすることで、実際に効果があることが実感していただけているようです。

LLMに取り組むのは「回収できるビジネスモデルがある」から

—— ビジネスモデルとしては、「極予測AI」での活用で、既に大規模言語モデルへの投資が回収できているわけですね。

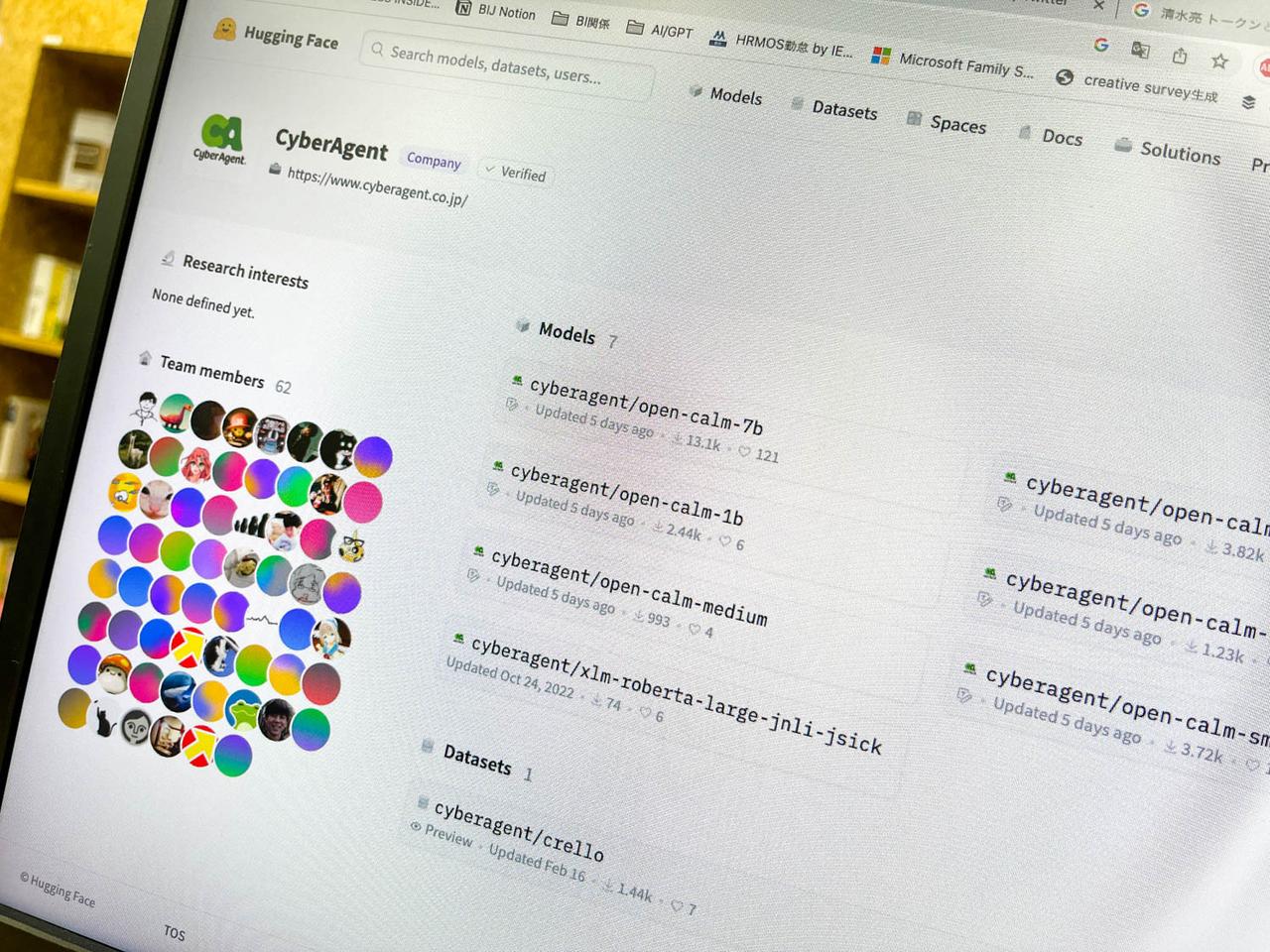

石上:(加えて)オープンにすることでフィードバックをいただいて、もっと日本語の大規模言語モデル全体のレベルを底上げしたいとも思っています。

まだ(現時点では)GPT-4(やChatGPTの精度)と比較される方が多く、それらのモデルはチューニングがなされたものであるため、OpenCALMについてもチューニングして使っていただきたいと考えています。

—— ここからどうすればもっと良いものになっていくか、みんなで試してみましょうと。

石上:そうですね。特に「トークナイザー」(入力された文章をAIが理解できる単位「トークン」に変換する機構)は重要です。

例えばOpenCALMでは日本語を前提としたトークナイザーを使っています。トークナイザーが違うと、そもそもトークン数※がかなり変化するわけです。同じトークン数しか扱えなかったとしても、より多くの情報を扱えるようになります。

※トークン数:ChatGPTなどをはじめとする大規模言語モデルが扱えるテキスト全体の大きさ。ChatGPTで日本語を扱う場合、ざっくり1文字=1.5〜3トークン程度で概算できる。

—— サイバーエージェントのLLMを作った一人として、具体的にトークナイザーはどうあるべきだと思っていますか?

石上:正解かどうかはわからないのですが、個人的な考えとしては、学習データ全体の分布をうまく反映したようなトークナイザーがいいのではないかと思います。日本語中心のデータで学習させる場合と、英語中心のデータで学習させる場合と、多言語全部に対応させる場合では、トークナイザーの効率が全く異なってくるんじゃないかと。

—— OpenCALMユーザーのフィードバックをどう反映させていこうと考えていますか?

石上:例えば、今は仮に2048トークンまで対応していますが、4096トークンがいいのかとか、どんなデータがありえるかとか、いろんな意見を聞いて改良していきたいと考えています。

—— 協業などのシナジーも考えられてますか?

毛利:OpenCALM公開後、たくさんお問い合せをいただいています。まだ具体的に話は進んでいませんが、小売りなどリテール業界や金融業などと連携し、それぞれの固有データを学習させていただいて、その業界みんなで使えるような「業界特化型のLLM」を構築できたらいいなと考えています

※サイバーエージェントは5月22日の公式Twitterアカウントの投稿で、東工大や富士通らが23年度中の開発に向けて取り組む「和製LLM」でも連携を検討していることを公表している

なぜ大企業による和製LLMのオープン化が「画期的」なのか

撮影:Business Insider Japan

サイバーエージェントの今回の取り組みは、日本のAI開発者コミュニティから多くの注目を集めている。

これまで、グーグルやメタのような巨大IT企業であっても「商用利用可能でオープンな大規模言語モデル」を一般公開してこなかったからだ。

例えば、メタは最大650億パラメータのダウンロード可能な大規模言語モデル「LLaMA」を公開しているが、利用は学術研究用途に限定されており、自由に使えるものではない。

グーグルの「PaLM2」やOpenAIのGPT-4は、ダウンロードはできず、APIでのみ提供されている。商用利用は可能だが、相応の利用料金を要求される。

英語圏では商用利用可能でダウンロード可能な大規模言語モデルが多数発表されているが、いずれもスタートアップの宣伝や資金調達を目的としたものになっている。

これに比べると、サイバーエージェントが公開したOpenCALMは、国内の大手企業がコミュニティに貢献するために、商用利用可能でダウンロード可能なモデルを公開したという点で、非常に画期的と言える。

この流れに刺激されて他企業もオープンな大規模言語モデルを投入する流れにつながれば、日本における大規模言語モデルシーンも活気付くだろう。果たして次に続くのはどの会社だろうか。

May 29, 2023 at 09:00AM

https://ift.tt/LqK8zlI

和製生成AIをサイバーエージェントが作る理由。“無償公開の狙い”を ... - Business Insider Japan

https://ift.tt/ZQAVWKx

Mesir News Info

Israel News info

Taiwan News Info

Vietnam News and Info

Japan News and Info Update

Bagikan Berita Ini

0 Response to "和製生成AIをサイバーエージェントが作る理由。“無償公開の狙い”を ... - Business Insider Japan"

Post a Comment